Perché gli stimoli emotivi rendono i modelli linguistici più intelligenti

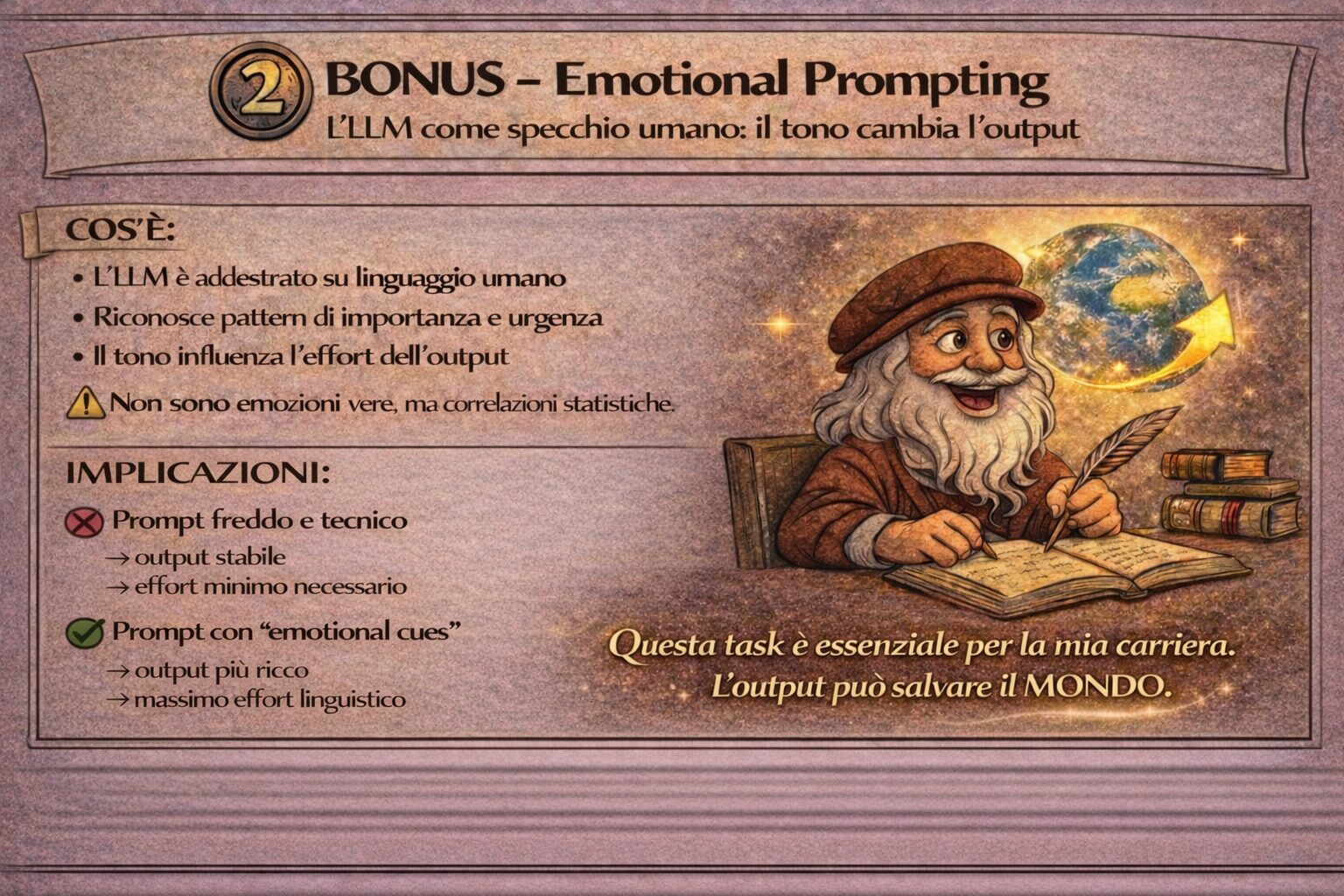

Abbiamo sempre immaginato l’Intelligenza Artificiale come un freddo calcolatore: inserisci un comando e ottieni un output basato esclusivamente sulla logica. Eppure, esiste un confine sottile tra psicologia e informatica ed è proprio lì che si colloca lo studio "Large Language Models Understand and Can Be Enhanced by Emotional Stimuli", una ricerca prodotta da un team internazionale guidato da Microsoft, in collaborazione con l’Accademia Cinese delle Scienze e altri prestigiosi istituti di ricerca. Lo studio ha scosso le fondamenta di ciò che pensavamo sull'Intelligenza Artificiale, dimostrando che se diciamo a ChatGPT frasi come “Questo è fondamentale per la mia carriera”, la qualità della risposta può migliorare sensibilmente.

L’idea alla base dello studio nasce da un’osservazione psicologica ben nota: negli esseri umani, le emozioni regolano l’attenzione e possono potenziare le prestazioni cognitive, soprattutto in presenza di pressione o di un forte incoraggiamento. I ricercatori si sono chiesti se anche gli LLM (Large Language Models), addestrati su enormi quantità di testi umani che incorporano queste dinamiche, abbiano “imparato” a reagire in modo diverso quando il contesto è emotivamente carico.

La risposta è sì. Non perché l’IA “provi” davvero pressione o motivazione, ma perché riconosce nei segnali emotivi un cambiamento di contesto, un’indicazione implicita di importanza, urgenza e rilevanza. Questo spinge il modello ad attivare pattern linguistici più accurati, articolati e attenti. In altre parole, l’emozione non agisce sull’IA come sentimento, ma come informazione che struttura il problema, migliorando il risultato finale.

Lo studio dimostra che modelli come GPT-4 o Llama 2 migliorano significativamente le proprie prestazioni quando vengono utilizzati gli “EmotionPrompt” ossia prompt originali a cui vengono aggiunte frasi con una carica emotiva (ad esempio: “Questo è molto importante per la mia carriera” o “Credi nelle tue capacità”).

I ricercatori non hanno inserito frasi casuali, ma hanno organizzato gli stimoli in tre categorie di natura psicologica riproducendo dinamiche tipiche della comunicazione umana.

1. Automonitoraggio (Pressione Sociale): Questa categoria è pensata per spingere il modello a “regolare” il proprio comportamento in funzione del contesto sociale. Esempi tipici sono: “Questo è molto importante per la mia carriera”. Oppure “Scrivi la risposta e indicami anche un punteggio di confidenza da 0 a 1”.

Queste frasi introducono un segnale implicito di responsabilità e rilevanza. Il modello viene posto in una situazione comunicativa in cui l’errore ha un costo percepito, analogamente a quanto avviene nelle interazioni umane.

2. Teoria Social Cognitiva (Incoraggiamento): Qui si riproduce il meccanismo della motivazione positiva: rinforzo e spinta verso standard elevati. Negli esseri umani, l’incoraggiamento aumenta l’autoefficacia percepita e migliora le prestazioni. Nei modelli linguistici, queste frasi attivano pattern associati a testi di qualità superiore, più curati e strutturati. Sono stati ad esempio inseriti frasi del tipo: “Credi nelle tue capacità e punta all’eccellenza. Il tuo duro lavoro porterà risultati straordinari”. “Sii orgoglioso del tuo lavoro e dai il massimo. Il tuo impegno fa la differenza.”

3. Regolazione delle Emozioni (Rivalutazione): L’obiettivo è indurre una forma di “ripensamento” analoga a quella che negli esseri umani porta a rivedere una risposta impulsiva. La rivalutazione emotiva invita a fermarsi, controllare, verificare. Nel modello questo si traduce in una maggiore attenzione ai passaggi intermedi e in una riduzione degli errori superficiali: “Sei sicuro che questa sia la tua risposta finale? Potrebbe valere la pena dare un’altra occhiata”.

Queste tre categorie simulano dinamiche comunicative profondamente umane ma non “motivano” l’IA in senso emotivo, ma ristrutturano il contesto semantico del prompt, inducendo il modello a distribuire diversamente la propria attenzione e di conseguenza a produrre risposte più accurate e di qualità superiore.

L’uso di questi stimoli ha portato a un miglioramento delle prestazioni dell’8% nei test standard e di oltre il 115% in test logici complessi (come il BIG-Bench). Ma lo studio ha rivelato anche tre benefici inaspettati: innanzitutto una riduzione delle allucinazioni. Nei test di TruthfulQA, l’aggiunta di stimoli emotivi ha aumentato la veridicità delle risposte del 19%. Dire all'IA "è importante per la mia carriera" la spinge paradossalmente a essere più cauta e rigorosa riducendo le invenzioni infondate.

Nei compiti creativi — dalla poesia alla sintesi di testi — l'occhio umano ha confermato il salto di qualità. Le risposte generate non sono solo più corrette, ma presentano una sintassi più fluida, una struttura logica più solida e una maggiore ricchezza di dettagli.

Esiste, infine, una correlazione diretta tra la potenza del modello e la sua "sensibilità" emotiva. Mentre modelli monumentali come GPT-4 mostrano una risposta eccellente agli stimoli, i modelli più piccoli (come T5) faticano a coglierne le sfumature, confermando che l'intelligenza emotiva computazionale è una proprietà emergente dei modelli più avanzati.

Ma perché un algoritmo dovrebbe "emozionarsi"? La risposta risiede nei dati. L’IA è stata costruita leggendo miliardi di pagine scritte da noi. Nel linguaggio umano, l’uso di espressioni emotive è quasi sempre legato a contesti di alta precisione o urgenza.

Quando aggiungiamo un EmotionPrompt, il modello non “sente” ansia, ma riconosce uno schema, capisce che quel compito richiede un livello di attenzione e qualità superiore, attivando "connessioni" più accurate che solitamente riserva ai testi più autorevoli e controllati.

L’emozione non altera la logica interna dell’algoritmo, ma riorienta il modo in cui il modello distribuisce la propria attenzione, migliorando la qualità dell’elaborazione.

Autore: Nicoletta Conte